Abo ut

Management von szenario-basierten Validierungsprozessen: Effizienz durch den Einsatz von Standards

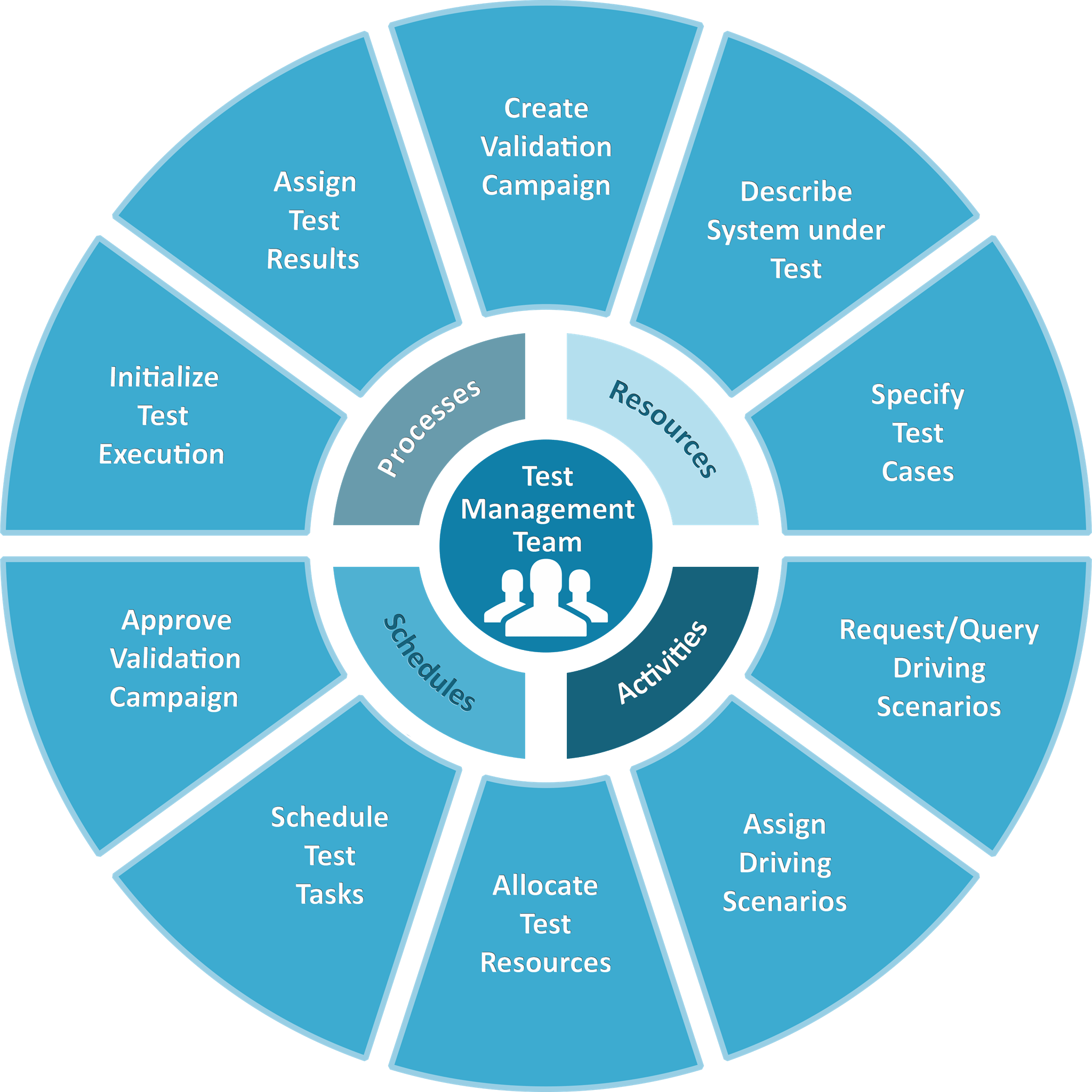

Aufgrund der Vielzahl möglicher Verkehrsszenarien und vielfältiger Validierungsmethoden ist die Bewertung der Sicherheit von autonomen Fahrfunktionen und Fahrerassistenzsystemen äußerst zeitaufwendig und komplex. Die Peak Test Management Suite (TMS) und eine Reihe von Industriestandards können bei der Implementierung einer Lösung helfen, mit der sich die komplexen Validierungsprozesse transparent steuern und die resultierenden Daten nachvollziehbar verwalten lassen.

Die Plattform ermöglicht dem Nutzer das effiziente Erstellen sogenannter Validierungskampagnen. Dies umfasst eine Liste vordefinierter Testfalltypen, die von einem oder mehreren Teams im Zuge der Validierung eines definierten „Systems unter Test“ durchgeführt werden müssen. Das zu prüfende System selbst kann aus mehreren Komponenten bestehen (z. B. Softwareversion, Steuergerät, Fahrzeugtyp etc.).

Neben den Testfällen und dem zu testenden System beinhaltet jede Validierungskampagne einen von TMS vorgeschlagenen Zeitplan sowie die Zuweisung geeigneter Testressourcen für jeden Testfall (z. B. spezifische XiL-Plattform, Testgelände, Testfahrzeug, Fahrer usw.). Der Benutzer kann jederzeit einzelne Testfälle hinzufügen oder löschen und die Validierungsaufgaben per Drag & Drop in einer Kalenderansicht neu planen. Erkennt TMS mögliche Planungskonflikte (z. B. die Mehrfachbelegung von Ressourcen), informiert es den Nutzer entsprechend.

Basierend auf „intelligenten“ Vorlagen kann der Anwender für jeden Testfall das jeweilige Ziel des Tests sowie einzelne Testparameter und -werte festlegen. Darüber hinaus kann er geeignete Metriken zur Bestimmung des Testabschlusses und der Testqualität definieren.

Ein wichtiger Bestandteil der Testfallbeschreibung ist die detaillierte Spezifikation des zu testenden Szenarios. Dies kann sowohl auf Basis individuell modellierter Beschreibungsstrukturen als auch auf Basis standardisierter Methoden, wie z.B. ASAM openLABEL, erfolgen. In einem verbundenen Szenario-Repository, z.B. basierend auf ASAM ODS, prüft der Anwender, ob bereits ein für seinen Testfall passendes Szenario vorhanden ist. Abhängig von der beabsichtigten Testmethode und Plattform kann er beispielsweise nach aufgezeichneten Szenarien suchen, die auf realen Straßenfahrten basieren, oder nach generischen Szenarien, basierend auf Szenario-Beschreibungs-Sprachen (SDLs), wie z.B. ASAM openSCENARIO. Ist das gewünschte Szenario verfügbar, kann er es mit seinem Testfall verknüpfen. Ansonsten hat er die Möglichkeit, eine Bereitstellungsanfrage zu erstellen, was einen weiteren Workflow anstößt (z.B. Beauftragung einer Aufnahme mit einem Testfahrzeug oder Generierung einer Szenario-Variante durch Parametrierung).

Nachdem die Testfalldefinition abgeschlossen und freigegeben wurde, können alle notwendigen Informationen in ein geeignetes Datenformat zur Initialisierung der Testausführung exportiert werden. Anschließend werden die konsolidierten Testergebnisse wieder importiert und dem Testfall zugeordnet. Umfangreichere Rohdaten aus der Testdurchführung (z.B. Traces, Logs, Busmeldungen etc.) werden in einem zentralen, testsystemunabhängigen Datenmanagementsystem gespeichert, z.B. basierend auf dem Peak Test Data Manager, und auch verlinkt. Dies gewährleistet die langfristige Nachvollziehbarkeit und Reproduzierbarkeit von Validierungsergebnissen für verschiedene Akteure.

Das Anwendungsszenario zeigt sehr gut, wie die Kombination eines ausgewählten Sets von Standards und Produktplattformen zu einer durchgängigen Werkzeugkette führt, die die Validierung autonomer Fahrfunktionen effizienter und nachvollziehbarer macht.